Du kan eller kan ikke ha hørt om prompt engineering. I hovedsak handler det om å "kommunisere effektivt med en AI for å få det du ønsker".

De fleste mennesker vet ikke hvordan de skal utforme gode oppgaver.

Imidlertid blir det en stadig viktigere ferdighet...

Fordi søppel inn = søppel ut.

Her er de viktigste teknikkene du trenger for å oppfordre 👇

Jeg vil referere til en språkmodell som 'LM'.

Eksempler på språkmodeller er @OpenAI’s ChatGPT og @AnthropicAI’s Claude.

1. Persona/rolle som gir en oppfordring

Tilordne en rolle til AI-en.

Eksempel: "Du er ekspert på X. Du har hjulpet mennesker med å gjøre Y i 20 år. Oppgaven din er å gi de beste rådene om X.

Svar 'forstått' hvis det er forstått."

En kraftig tilleggsmodul er følgende:

‘Du må alltid stille spørsmål før du svarer, slik at du kan forstå bedre hva spørsmålsstilleren søker.’

Jeg vil snakke om hvorfor det er så viktig om et øyeblikk.

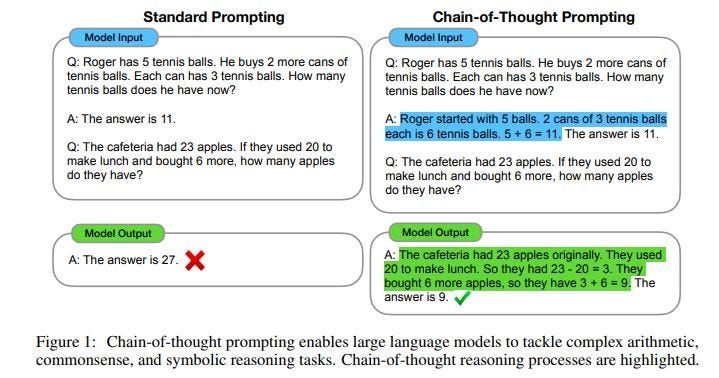

2. CoT

CoT står for 'Chain of Thought'

Det brukes for å instruere LM om å forklare sin resonnement.

Eksempel:

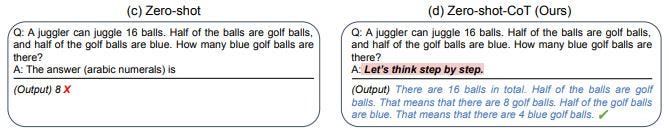

3. Nullskudd-CoT

Zero-shot refererer til en modell som gjør prediksjoner uten ekstra trening innenfor prompten.

Jeg kommer til å komme tilbake til few-shot om et øyeblikk.

Merk at vanligvis CoT > Zero-shot-CoT

Eksempel:

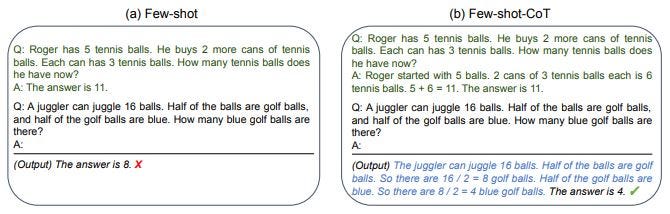

4. Few-shot (og few-shot-CoT)

Few-shot er når LM får noen få eksempler i oppgaven for at den raskere skal kunne tilpasse seg nye eksempler.

Eksempel:

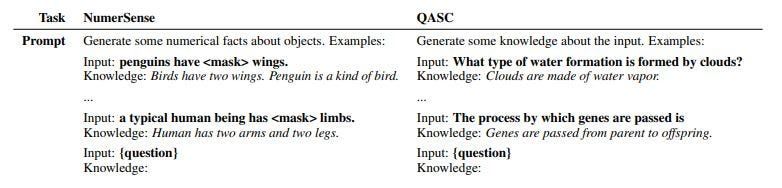

5. Kunnskapsgenerering

Generering av spørsmålsrelatert kunnskap ved hjelp av en LM.

Dette kan brukes til en generert kunnskapsprompt (se nærmere).

Eksempel:

6. Generert kunnskap

Nå som vi har kunnskapen, kan vi mate den informasjonen inn i en ny forespørsel og stille spørsmål relatert til kunnskapen.

En slik spørsmål kalles et 'kunnskapsforsterket' spørsmål.

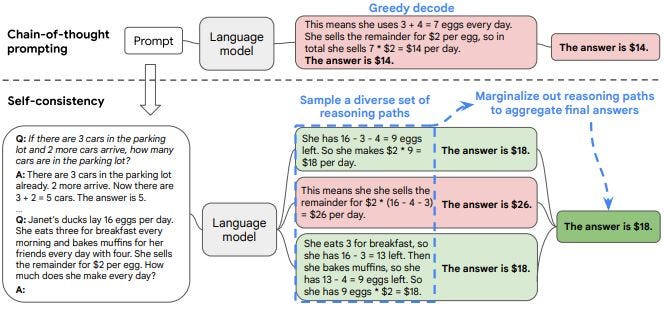

7. Selv-konsistens

Denne teknikken blir brukt for å generere flere resonnementstier (tankerekker).

Flertallet svar betraktes som det endelige svaret.

Eksempel:

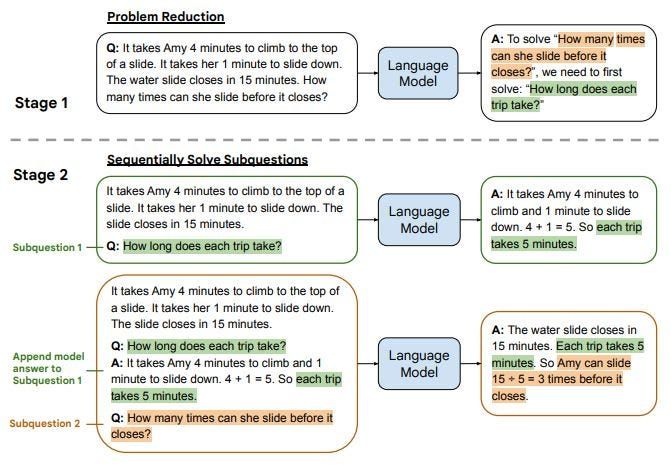

8. LtM

LtM står for ‘Least to Most’

Denne teknikken er en oppfølging av CoT. I tillegg fungerer den ved å dele et problem ned i underproblemer og deretter løse dem.

Eksempel: